Новый сервис про заработок в интернете на заданиях, позволяющий вступить в «семью».

Кто сказал, что доски объявлений не работают? Если вы не знали, то большая часть ваших клиентов как раз и ищут, то, что вы продаёте именно здесь.

Большая база досок объявлений, состоящая из 471 штуки;

Большая база досок объявлений, состоящая из 471 штуки;Регистрация занимает 17 минут;

Ты сможешь сам распределять время подачи объявлений.

Всего досок объявлений: 471

Участников системы: 573469

Сегодня новых: 893

Вчера: 1386

Напоминаем, что добавить объявление в нашу базу досок вы можете за 79 рублей. Мы гарантируем качество.

Трастовые белые каталоги – это ценность для любого размещаемого сайта, за счёт повышения трастовости ресурса и поведенческих факторов.

Собственная база из 2183 белого каталога статей с ТИЦ от 30;

Собственная база из 2183 белого каталога статей с ТИЦ от 30;Ты вправе сам распределять время размещения своих статей;

Ты ещё думаешь?

Всего каталогов статей: 2183

Участников системы: 473964

Сегодня новых: 692

Вчера: 981

Напоминаем, что добавить статьи в наши каталоги статей вы можете за 379 рублей. Мы гарантируем качество.

79 рублей привлечь клиентов с помощью нашего сервиса!

регистрация

Если вы ещё думаете, что новому сайту не нужна регистрация в каталогах статей или досках, то это 100% заблуждение. Как показывает наша статистика, более 87% вновь добавленных сайтов в нашу систему, начинают эффективно индексироваться в Яндексе и Гугле уже спустя пару дней, а уже через 5-9 дней имеют подъём по НЧ запросам в поисковых системах, например, таких как Гугл..

База предлагаемая для регистрации была вручную отобрана и относится к 4-му кварталу 2018 года, так что советуем воспользоваться нашим сервисом для регистрации не только на досках объявлениях, но и так же в тематических каталогах статей.

Этапы регистрации в нашем сервисе

Банальная регистрация

Банальная регистрацияв системе, дабы завести себе аккаунт. Наверно особо писать здесь нечего. Спасибо.

Двигаемся далее

Создаём проект,

Создаём проект,наполняем его информацией для успешной регистрации. Указываем свой сайт.

Двигаемся далее

Процесс регистрации

Процесс регистрациинапоминает взлёт ракеты, где отчёт регистрации показан в процентах.

Поехали?

Получаем полный отчёт

Получаем полный отчёто всех добавленных объявлениях. Пожалуй это самая приятная часть.

Наслаждаемся бэками

Прогон сайта

Работа с Sitemap.xml и Robots.txt

Robots.txt в большинстве случаев используется для исключения дубликатов, служебных страниц, удаленных страниц и других ненужных страниц из индекса поисковых систем. Кроме того, именно через robots.txt можно указать ПС главное зеркало сайта и адрес карты сайта. В некоторых случаях к robots.txt прибегают для того, чтобы закрыть сайт от нежелательной поисковой системы. Правильное манипулирование robots.txt позволяет перенаправлять бота ПС на нужные страницы, не разрешая создавать дубли контента, приводящие к понижению понизиций.

Файл robots.txt должен располагаться строго в корне сайта, он должен быть единственным, число директив (команд) не должно превышать 1024.

Если основное предназначение robots.txt – это запрет индексации, то карта сайта sitemap.xml выполняет прямо противоположные задачи. Она отвечает за ускорение индексации сайта и полноту индексации сайта.

Sitemap.xml указывает поисковой системе частоту, с которой возникает необходимость в переиндексации страниц. В этом плане инструкция особенно важна для сайтов с регулярно обновляющимся контентом (новостные порталы и т. п.). Кроме того, sitemap.xml содержит все важные страницы сайта с указанием их приоритета.

Общее число sitemap.xml на сайте не должно превышать 1000, при этом число записей (урлов) в каждом не должно превышать 50 000 штук.

Инструкции sitemap.xml и robots.txt при правильном их использовании должны дополнять друг друга. Существуют три правила взаимодействия этих инструкций:

• sitemap.xml и robots.txt не должны противоречить друг другу;

• все страницы, исключенные в robots.txt, должны быть исключены также из sitemap.xml;

• все индексируемые страницы, разрешенные в robots.txt, должны содержаться в sitemap.xml

Мы не будем расписывать прописные истины и копипастить в руководство документацию по составлению robots.txt – для этого есть множество хороших ресурсов, строго рекомендуемых для изучения: http ://robotstxt.org.ru/ - для SEOшников начального уровня обязательно к изучению и осмыслению. http ://help.yandex.ru/webmaster/?i d=996567 – документация от Яндекс http ://support.google.com/webmasters/bin/answer.py?hl=ru&answer=156449 – от Гугла.

Что необходимо проверить даже самому великому гуру SEO: 1. Наличие / отсутствие ошибок и описок в robots.txt 2. Прогнать валидацию для каждой из ПС в чекере вебмастера 3.

Проследить что синтаксис яляется правильным для каждой из ПС (так как практически все они поддерживают свои расширенные форматы)

По последнему пункту, у Яндекса есть несколько интересных самостийных директив, например Директива Clean-param:

Если адреса страниц вашего сайта содержат динамические параметры, которые не влияют на их содержимое (например: идентификаторы сессий, пользователей, рефереров и т.п.), вы можете описать их при помощи директивы 'Clean-param'. Робот Яндекса, используя эту информацию, не будет многократно перезакачивать дублирующуюся информацию. Таким образом, увеличится эффективность обхода вашего сайта, снизится нагрузка на сервер.

Например, на сайте есть страницы:

www.site.ru/some_dir/get_book.pl?ref=site_1&book_id=123 www.site.ru/some_dir/get_book.pl?ref=site_2&book_id=123 www.site.ru/some_dir/get_book.pl?ref=site_3&book_id=123 параметр 'ref=' используется только для того, чтобы отследить с какого ресурса был сделан запрос и не меняет содержимое, по всем трем адресам будет показана одна и та же страница с книгой 'book_id=123'. Тогда, если в robots.txt указать:

Clean-param: ref /some_dir/get_book.pl Вот так:

User-agent: Yandex Disallow: Clean-param: ref /some_dir/get_book.pl Робот Яндекса сведет все адреса страницы к одному:

www.site.ru/some_dir/get_book.pl?ref=site_1&book_id=123, Если на сайте доступна страница без параметров:

www.site.ru/some_dir/get_book.pl?book_id=123 То все сведется именно к ней, когда она будет проиндексирована роботом.

Другие страницы вашего сайта будут обходиться чаще, так как нет необходимости обновлять страницы: www.site.ru/some_dir/get_book.pl?ref=site_2&book_id=123

www.site.ru/some_dir/get_book.pl?ref=site_3&book_id=123

Безусловно полезная директива, при наличии партнерской программы на сайте. При этом прямой альтернативы у Гугла нет и приходится прописывать rel="canonical" непосредственно в заголовке страницы.

Таким образом, рекомендую еще раз перепроверить ваши robots.txt, прочекать их на основные ошибки:

http ://robotstxt.org.ru/robotstxterrors

Ещё по теме:

» Категория: Прогон сайта

Каталоги и доски для регистрации

Выбери свой тариф

Новый принцип револьвера для твоего сайта

Отзывы о системе и её работе

Начальник отдела маркетинга

Начальник отдела маркетингаАлексей

Зам. ген. директора.

Зам. ген. директора.Артур

Ген. директор.

Ген. директор.Михаил

Новости сервиса

Друзья, новое обновление в 2018 году трастовой базы сайтов, которое производилось вручную...

Друзья, новое обновление в 2018 году трастовой базы сайтов, которое производилось вручную...

Друзья, первое обновление в 2018 году трастовой базы сайтов, которое производилось вручную...

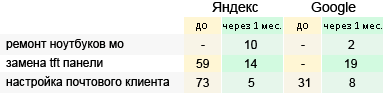

Регистрация в белых каталогах статей сразу в ТОП 3 Яндекса

Примеры, которые лучше других показывают уровень отдачи от регистрации по нашей базе трастовых каталогов.

Преимущества нашей системы основные плюсы

А при составлении контента для подачи в трастовые каталоги, можно использовать несколько анкоров, что только повышает отдачу для вашего сайта.

Наш сервис является уникальным в своём роде, позволяя не только наращивать бэки и ТИЦ, но и за не большую плату выводить в ТОП разные запросы.

Если говорить о качестве данных каталогов, то среди прочего можно выделить ТИЦ и быстроту индексации вновь добавленных статей.

А размещение в нашей базе трастовых каталогов происходит за менее часа для 1 сайта, так как она полностью оптимизирована.

О системе

Новости системы

Зарегистрироваться

О нас

База каталогов для регистрации

Вопросы по системе

Контакты

Маркетинг 2016 года

Seo гуру

Веб ресурс

Продвижение веб сайта

Умное продвижение

Поднять ТИЦ бесплатно

Плюсы интернет рекламы

Новые виды маркетинга

Психология рекламы

Безлимитный ответ

Текст подачи объявления

Реклама на сайте