Новый сервис про заработок в интернете на заданиях, позволяющий вступить в «семью».

Кто сказал, что доски объявлений не работают? Если вы не знали, то большая часть ваших клиентов как раз и ищут, то, что вы продаёте именно здесь.

Большая база досок объявлений, состоящая из 471 штуки;

Большая база досок объявлений, состоящая из 471 штуки;Регистрация занимает 17 минут;

Ты сможешь сам распределять время подачи объявлений.

Всего досок объявлений: 471

Участников системы: 573469

Сегодня новых: 893

Вчера: 1386

Напоминаем, что добавить объявление в нашу базу досок вы можете за 79 рублей. Мы гарантируем качество.

Трастовые белые каталоги – это ценность для любого размещаемого сайта, за счёт повышения трастовости ресурса и поведенческих факторов.

Собственная база из 2183 белого каталога статей с ТИЦ от 30;

Собственная база из 2183 белого каталога статей с ТИЦ от 30;Ты вправе сам распределять время размещения своих статей;

Ты ещё думаешь?

Всего каталогов статей: 2183

Участников системы: 473964

Сегодня новых: 692

Вчера: 981

Напоминаем, что добавить статьи в наши каталоги статей вы можете за 379 рублей. Мы гарантируем качество.

79 рублей привлечь клиентов с помощью нашего сервиса!

регистрация

Если вы ещё думаете, что новому сайту не нужна регистрация в каталогах статей или досках, то это 100% заблуждение. Как показывает наша статистика, более 87% вновь добавленных сайтов в нашу систему, начинают эффективно индексироваться в Яндексе и Гугле уже спустя пару дней, а уже через 5-9 дней имеют подъём по НЧ запросам в поисковых системах, например, таких как Гугл..

База предлагаемая для регистрации была вручную отобрана и относится к 4-му кварталу 2018 года, так что советуем воспользоваться нашим сервисом для регистрации не только на досках объявлениях, но и так же в тематических каталогах статей.

Этапы регистрации в нашем сервисе

Банальная регистрация

Банальная регистрацияв системе, дабы завести себе аккаунт. Наверно особо писать здесь нечего. Спасибо.

Двигаемся далее

Создаём проект,

Создаём проект,наполняем его информацией для успешной регистрации. Указываем свой сайт.

Двигаемся далее

Процесс регистрации

Процесс регистрациинапоминает взлёт ракеты, где отчёт регистрации показан в процентах.

Поехали?

Получаем полный отчёт

Получаем полный отчёто всех добавленных объявлениях. Пожалуй это самая приятная часть.

Наслаждаемся бэками

Прогон сайта

Оценка качества сайтов и выход из под фильтров

В каждой поисковой системе имеются собственные разновидности фильтров, накладываемых на сайты. Однако для всех поисковых систем их можно подразделить на несколько схожих групп, методики вывода сайта из под которых будут весьма схожи.

К первой группе принадлежат «ручные» фильтры, как правило накладываемые асессорами поисковой системы. Выход из под них наиболее труден и долог из за необходимости общения с ассесорами и предоставления доказательств устранения нарушений лицензий поисковых систем и требований к качеству сайта.

Как правило, в вебмастере Гугля появляется уведомление о наложении ручных фильтров, которое предупреждает об использоании неестественных.

ссылок с целью наращивания PR. В яндексе это может быть (или не быть) сообщение от Платонов о наложении санкций на сайт.

Второй группой фильтров, которые затрагивают в разы большее число вебмастеров - являются алгоритмические фильтры. Все они накладываются по совокупности «прегрешений» сайта автоматически.

С одной стороны достаочно убрать «перекосы» в методах оптимизации сайта (перспам кеями, избыточную перелинковку, переспам внешними линками и пр..), как фильтры будут автоматически сняты с вашего сайта.

Однако тут есть несколько особенностей: − во первых, характеризующих коэффициентов у сайта - несколько сотен и мы можем лищь эмпирически определять влияние и весовые коэффициенты этих факторов. − Во вторых, с изменениями алгоритмов, весомость отдельных факторов заметно изменяется, поэтому диагностировать что именно нужно править в первую очередь - можно только эмпирически.

Наиболее известными алгоритмическими фильтрами на данный момент являются Пингвин от Гугла, Панда от Гугла и АГС от Яндекса. Все эти алгоритмические фильтры прошли уже не один апдейт и накрыли в общей сложности большую часть продвигаемых спам методами сайтов.

Если говорить об иных фильтрах, таких как минус 30 позиций за линкбомбинг и т.д., то все они органически вошли составляющими упомянутого выше Пингвина. Теперь по проседанию позиции запроса на определенное число позиций уже не отследить и не понять какая составляющая алгоритмического фильтра настигла сайт.

К сожалению, в отличии от наложенных Гуглом ручных фильтров, как правило Гугл не уведомляет в вебмастере о наказании.

Итак, основными фильтрами, понижающими позиции запроса в выдаче являются ручные и алгоритмические фильтры.

Я уже рассказывал на страницах Lipf.Ru как мы выводили сайт из под Панды: http ://lipf.ru/kak-shhelknut-pandu-po-nosu.html

Привожу пошаговая техника аудита сайта для его изменения и совершенствованя:

Шаг 1. Ищем слабые и некачественные страницы сайта Вы должны понимать, что слабые, некачественные и дублирующие контент страницы уменьшают траст сайта и приводят к значительной просадке в выдаче. Я использую такой инструмент (платный)

http ://www.opensiteexplorer.org/pages?site=lipf.ru

Для поиска дублей приоритетных страниц на сайте можно использовать Copyscape. Собираю все страницы в Excel, сортирую по MOZрангу.

ВАЖНО: НАИБОЛЕЕ БЫСТРЫМ СПОСОБОМ ОПРЕДЕЛЕНИЯ КАЧЕСТВА СТРАНИЦЫ ЯВЛЯЕТСЯ ПРОВЕРКА ЕГО TITLE В СЕРПЕ – НУ ЕСТЕСТВЕННО, ЕСЛИ ОН МНОГОСЛОВНЫЙ.И УНИКАЛЬНЫЙ.

Если страница НЕ НАХОДИТСЯ под фильтрами, то ваш Титл будет определятся на первом месте.

Более долгим, но более качественным и надежным способом является определение нахождения в топе по выдержкам с вашей страницы. Берется кусок предложения в 6-8 слов и в кавычках забивается в гугль. Далее мы смотрим:

1. есть или нет это строгое вхождения в выдаче

2. если оно есть, то нет ли его на других сайтах (ваше вхождение единственное в выдаче) 3. если оно не единственное в выдаче, то на каком месте стоит (первое или стоит после других сайтов)

Эта операция повторяется 3-4 раза для каждой страницы.

Эта операция выполняется ДЛЯ ВСЕХ страниц сайта.

Тов. sNOa для внутренних целей написал программу, которая парсит такие выдержки с сайта и автоматом определяет некачественные/ качественные страницы.

Скачать оный софт можно здесь: http ://content-monster.com/download/cm2sitechecker-inst.exe Софт выдается как есть, он написан для собственного пользования, посему никакой поддержки по нему нет и не будет, однако если возникнут вопросы по его работе, то их можно задать тов. sNOa на форуме http ://blap.ru/forum/

Шаг 2. Удаляем некачественные страницы Удаляем некачественные страницы и дубли из серпа (через вебмастерс), одновременно закрываем их в noindex в аттрибутах, либо в robots.txt. После этого я или улучшаю качество страниц, переписывая контент и насыщая его «длинными хвостами запросов», либо удаляю. Рекомендую улучшать качество страниц, пока они закрыты от индексации, чтобы восстановить траст сайта, после того как страницы будут готовы к переиндексации.

Тут же проверяем переспам страницы в урле и фиксим эту проблему (см тут http ://lipf.ru/kak-shhelknut-pandu-po-nosu.html)

Шаг 3. Исправляем 404 ошибки

Заходим в гугл вебмастерс и проверяем страницы на 404 ошибки

Если 404 ошибка вызвана ссылкой внутри сайта из за перелинковки – то исправляем такие ошибки, корректируя ссылочное. Внешние ссылки на несуществующие страницы перенаправляем 301 редиректом на морду или продающие страницы. http ://lipf.ru/htaccess-301-redirekt.html Повторяем операцию, используя данные Яндекс вебмастера.

Шаг 4. Связываем трастовые страницы с продающими Основываясь на показателях MOZранга и PR страниц, числу входящих и числу социальных сигналов – выбираем наиболее трастовые страницы ресурса и ставим с них ссылки на продающие страницы, используя разнообразные ключи в анкорах. Соблюдайте принцип близкотематичности ссылающихся страниц – продающим страницам.

Шаг 5. Ищем высокотрафиковые страницы и развиваем их Выделяем страницы, которые добились максимального трафика как на настоящий момент, так, и в случае наложения фильтра Панды от гугла – в прошлом и помечаем их как приоритетные страницы. Аналогично в группу приоритетных страниц выделяем те страницы, у которых минимальное число отказов (используйте данные Гугл Аналитикс и Яндекс Метрики).

Для этих страниц улучшаем и дополняем контент, строим ссылочное, отслеживаем позиции в серпе по ключевым словам для них.

Если страницы не являются продающими, то настраиваем на них продажные блоки или вынуждаем каким либо образом перейти с этой страницы на продающую страницу.

Шаг 6. Оптимизируем важные страницы сайта Инспектируем главную страницу сайта, все продающие страницы сайта и определяем число отказов/переходов/действий на этих страницах. Основываясь на этих данных меняем структуру страницы, переписываем контент, делаем его максимально уникальным, добавляем полезные разделы, материалы, предлагаем комплексные решения, скидки или иные мероприятия, в зависимости от тематики вашего сайта.

Шаг 7. Оптимизируем скорость загрузки ключевых страниц Включаем кэширование, избавляемся от сторонних элементов, пережимам графику, удаляем ненужную рекламу. Скорость загрузки важных страниц – критический показатель, ведь некоторое число посетителей уходят с них, не дождавшись загрузки – а это сигнал ПС о некачественности контента и / или плохой юзабельности сайта.

Шаг 8. Интеграция в сайт блога Для магазинов или больших коммерческих ресурсов – это необходимый шаг электронной комерции с одной стороны, с другой вы можете постоянно поддерживать продающие страницы сайта новыми публикациями в блоге, а с третьей – вы получаете дополнительное число социальных сигналов на сайт, а с четвертой – вы цепляете длинный хвост разных НЧ запросов.

Шаг 9. Для каждого важного ключа создаем поддерживающую страницу Выделяем важнейшие ключи сайта и разносим их по отдельным поддерживающим страницам, создавая высококачественный контент для этого ключа. Эти поддерживающие страницы, оптимизированные под каждый ключ связываем с продающими страницами.

Шаг 10. Ссылочная разведка Анализируем ссылочное конкурентов в топе, либо конкурентов не затронутых фильтром Гугл Панда, выделяем максимально релевантные вашему сайту и стараемся разместить на них ссылки.

Шаг 11. Проверка robot.txt Собираем и анализируем robot.txt конкурентов в топе по отдельным ключевым словам, смотрим как организована структура сайта у них, какие разделы (архивы, категории, тэги,авторы, отдельные подразделы) закрыты у них от индексирования и каким образом это повлияло на выдачу. Анализируем тэг canonical на страницах сайта. Обязательно закрываем в роботсе все урлы с переадресацией на внешнии ресурсы (например при использовании в вордпрессе плагина Pretty Link).

Шаг 12. Анализ страниц конкурентов Выделяем самые трастовые страницы конкурентов в торпе, используя OpenSiteExplorer, ищем для них дубликаты на сайте конкурента через CopyScape и определяем технику оптимизации таких страниц, пытаемся перенять и внедрить эту стратегию на своем сайте.

Шаг 13. Анализируем трафик конкурентов Проводим анализ основных ключевых слов, по которым приходит наибольший трафик на конкурентов, используя статистику LI (если есть доступ), SEMrush или иные методы. После этого смотрим, на какие страницы идет этот трафик, насколько они авторитетны по MOZрангу и какие методы оптимизации страниц использовали конкуренты. После чего внедряем эту практику на своем сайте.

Шаг 14. Ищем возможности проставить релевантную ссылку Постоянно ищем возможности проставить релевантную ссылку на ваш сайт с релевантного ресурса. Для этого можно использовать методики поиска доноров в Поисковых системах, размещение ссылок в тематических каталогах, комментариях мощных блогов и пр.

Шаг 15. Составляем отчетность о конкурентах Ведем в Excel лист разведданых о конкурентах, где указываем все важнейшие характеристики (место в топе по ключу, авторитет по Мозрангу, число ссылающихся сайтов и т.д.). Периодически инспектируйте изменения в ТОПе и проводите анализ сайтов конкурентов, определяя методики их продвижения

Шаг 16. Анализ изменений Периодически проводите анализ изменений позиций в ТОПе и сопоставляйте их со своими работами. Не ленитесь тщательно конспектировать – что вы проделывали на сайте и к каким изменениям это привело. Отслеживайте рост MOZранга, PR, входящего ссылочного на свои главные страницы, сравнивайте их с конкурентами, ищите соответствия между проделанными работами и положением в ТОПе.

Выводы: 1. Удаляем некачественные страницы, дубли и 404 ошибки, как не позволяющие вашему сайту выйти в ТОП 2. Оптимизируем урлы сайта, избавляемся от переспама в урлах

3. Для сайтов электронной коммерции, содержащие большое число карточек товаров – разворачиваем описания в текст, например плагином «Генератор Магазинов». Добиваемся высокой уникальности этих карточек 4. Сосредотачиваемся на получение высококачественных ссылок с релевантных сайтов для продвижению нужных ключей 5. Переоптимизируем важные страницы, делаем на них перелинковку

Выход из под фильтра Пингвин от Google

Фильтр накладывается при переспаме кеями и неправильной анкор группе вашего сайта. Характерный признак – строгий поиск цитат контента (поиск в кавычках куска текста в 7-10 слов), выдает ваш сайт не на первом месте. Второй признак – резкое падение трафика в период с 25 апреля.

Важная особенность фильтра – что он накладывается на отдельные страницы сайта и отдельные запросы, что помогает в борьбе с ним.

Итак, нами апробированы 3 способа выхода из под фильтра Панды, зарекомендовавшие себя достаточно хорошо.

Первый - снятие ссылок со страниц с большим PR (3-8) имеющим «денежный анкор». Нами было зарегистрировано, что этот метод приводит к выходу из под фильтров в 25-30% случаев.

Второй метод – постраничный 301 редирект на новый урл. Как разновидность его – это 301 редирект зафильтрованной страницы внутри сайта на иную страницу – т.е. изменение урла продающей страницы. К сожалению данный метод не оправдал себя. Спустя 2 месяца сайт опять оказывается под фильтрами Пингвина.

Единственным способом выхода из под фильтров является удаления некачественных ссылок, плавного повышения доли бренда в анкор листе вашего сайта до 50% и повторной подачи запроса.

Сейчас в вебмастере Гугла доступен импорт всей ссылочной массы вашего сайта – обязательно займитесь его анализом.

Прежде чем воздействовать на сайт – обязательно разберитесь что за фильтр на него напал. Возможно это не Пингвин, а панда и тогда нужно проделать комплекс мероприятий из раздела 7.1.

Для диагностирования проблемы с фильтром Панда, откройте например OpenSiteExplorer и введите туда урл вашего проекта.

Далее уберите из списка ссылок внутренние, 301 редиректы и закрытые тэгом Nofollow (последние не учитываются в Пингвинофильтре при наказании).

Теперь сосредоточьтесь на столбце «анкоры». Если более половины из них - неестественные и продажные анкоры, то с большей долей вероятности на вас наложен Пингвинофильтр.

Как показывает статистика, разумеется разная для различных регионов и целевых ниш, доля естественных ссылок, таких как бренд сайта и разнообразные безанкорные составляющие в анкор листе авторитетного сайта занимают более 90%. Таким образом, вычисление искусственно продвигаемых проектов является довольно тривиальной задачей.

Вам необходимо еще раз изучить главу, посвященную брендированию проекта и изменить свое мировозрение по поводу покупки ссылок при продвижении в Google.

Ещё по теме:

» Категория: Прогон сайта

Каталоги и доски для регистрации

Выбери свой тариф

Новый принцип револьвера для твоего сайта

Отзывы о системе и её работе

Начальник отдела маркетинга

Начальник отдела маркетингаАлексей

Зам. ген. директора.

Зам. ген. директора.Артур

Ген. директор.

Ген. директор.Михаил

Новости сервиса

Друзья, новое обновление в 2018 году трастовой базы сайтов, которое производилось вручную...

Друзья, новое обновление в 2018 году трастовой базы сайтов, которое производилось вручную...

Друзья, первое обновление в 2018 году трастовой базы сайтов, которое производилось вручную...

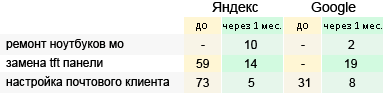

Регистрация в белых каталогах статей сразу в ТОП 3 Яндекса

Примеры, которые лучше других показывают уровень отдачи от регистрации по нашей базе трастовых каталогов.

Преимущества нашей системы основные плюсы

А при составлении контента для подачи в трастовые каталоги, можно использовать несколько анкоров, что только повышает отдачу для вашего сайта.

Наш сервис является уникальным в своём роде, позволяя не только наращивать бэки и ТИЦ, но и за не большую плату выводить в ТОП разные запросы.

Если говорить о качестве данных каталогов, то среди прочего можно выделить ТИЦ и быстроту индексации вновь добавленных статей.

А размещение в нашей базе трастовых каталогов происходит за менее часа для 1 сайта, так как она полностью оптимизирована.

О системе

Новости системы

Зарегистрироваться

О нас

База каталогов для регистрации

Вопросы по системе

Контакты

Маркетинг 2016 года

Seo гуру

Веб ресурс

Продвижение веб сайта

Умное продвижение

Поднять ТИЦ бесплатно

Плюсы интернет рекламы

Новые виды маркетинга

Психология рекламы

Безлимитный ответ

Текст подачи объявления

Реклама на сайте